《DeepSeek 发布 mHC 架构:AI 模型 “智能稳定器” 重塑大模型研发范式》

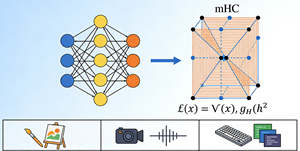

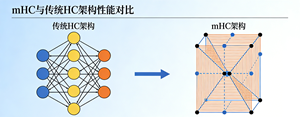

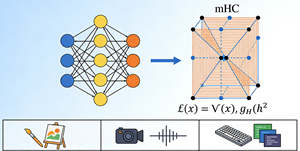

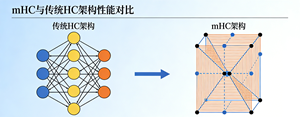

DeepSeek 于 2025 年 12 月 31 日在 arXiv 发布 mHC(流形约束超连接)架构,以 “双随机矩阵流形约束 + 高效算法投影” 为核心,为大模型装上 “智能稳定器”,在保留超连接性能增益的同时,从数学上根治训练信号爆炸、梯度不稳定等问题,推动架构设计从 “经验驱动” 转向 “理论驱动”,重塑大模型研发范式。以下为深度解析:

范式升级:标志大模型研发从 “堆参数 / 算力” 转向 “拓扑结构 + 数学约束” 的精细化设计,为后 Transformer 时代提供新方向。

成本优化:降低大规模训练的失败风险与算力浪费,助力开源模型与中小企业高效迭代。

生态拓展:适配 AI 生成、视频理解、代码生成等复杂场景,推动模型在边缘设备与低功耗场景稳定落地。